Heute überfluten uns Spiele in einem endlosen Strom. Bibliotheken platzen mit Hunderten Titeln, von denen…

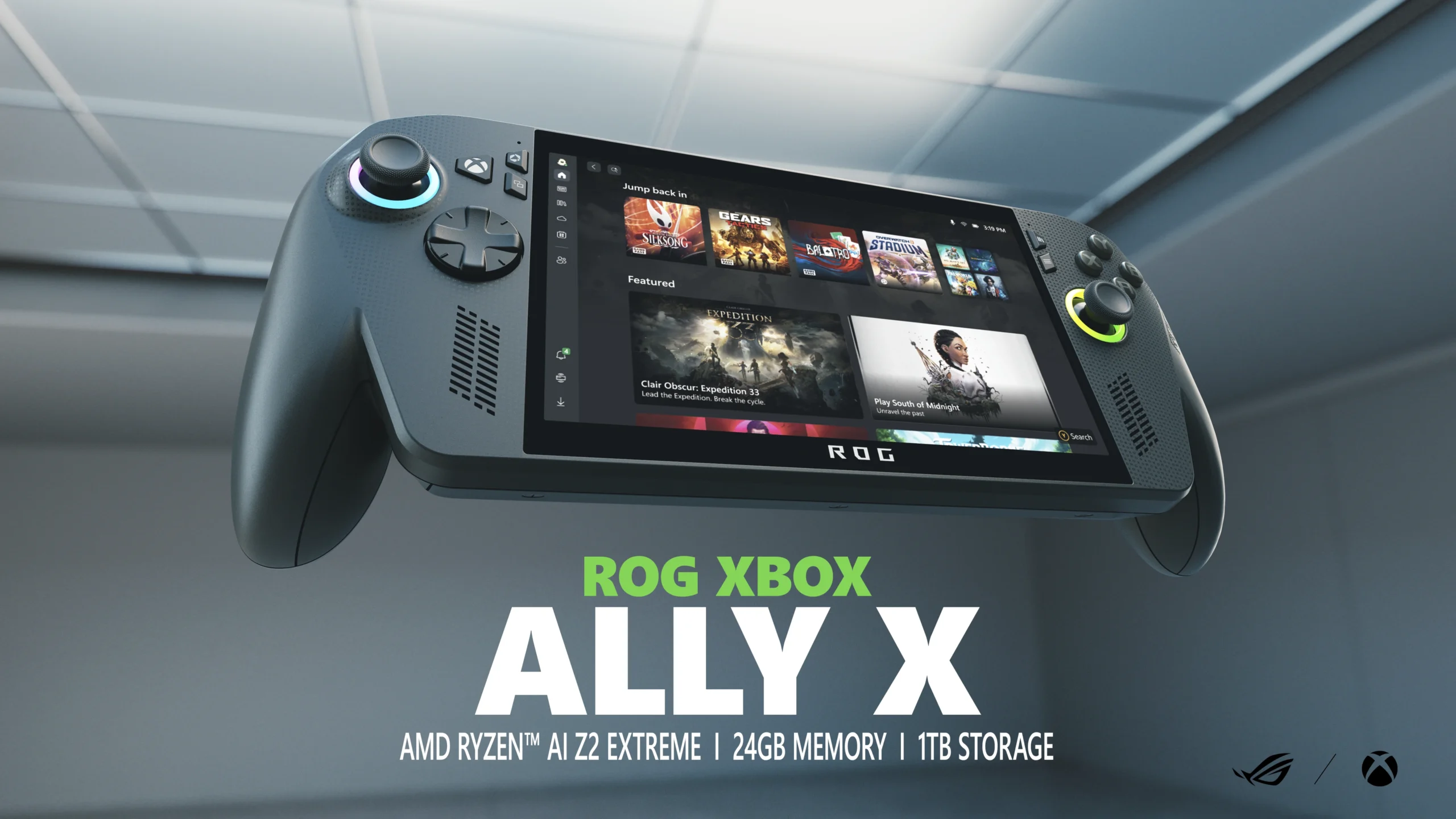

ROG Xbox Ally X – Hoffnungsträger oder nur ein weiterer Marketing-Gag von Microsoft?

Die Gaming-Welt liebt neue Hardware. Kaum kündigt ein großer Hersteller ein neues Gerät an, kocht…

Test: NVIDIA GeForce RTX 5050 – Ein Fehlstart im Einsteigersegment

Mit der GeForce RTX 5050 bringt NVIDIA die kleinste Karte seiner aktuellen Generation auf den…

RTX 5050 – Enttäuschung für rund 330 Euro

Mit der RTX 5050 präsentiert NVIDIA den offiziellen Nachfolger der Einsteigerkarte RTX 3050. Eigentlich sollte…

Test: ASUS ROG Zephyrus G16 (2025) GU605C

ASUS hat mit dem neuen ROG Zephyrus G16 GU605C ein Gaming-Notebook auf den Markt gebracht,…

Gears of War: Reloaded erscheint mit Day-One-Patch

Das neueste Kapitel der legendären Shooter-Reihe ist da: Gears of War: Reloaded ist ab sofort…

Sony kündigt PlayStation-5-Bundle mit NBA 2K26 an

Sony hat gemeinsam mit 2K Games ein neues Konsolen-Bundle angekündigt: Zum Release von NBA 2K26…

EA kündigt Verbesserungen für Battlefield 6 nach Beta-Feedback an

Electronic Arts hat nach Abschluss der Battlefield 6-Beta angekündigt, dass auf Grundlage des Spieler-Feedbacks mehrere…

Nintendo veröffentlicht erste Stop-Motion-Animationen rund um Mario

Nintendo hat die ersten drei Episoden einer neuen Kurzanimationsreihe mit dem Titel „It’s Me, Mario!“…

Final Fantasy-14-Regisseur Yoshida: „PS6 und neue Xbox sind nicht notwendig“

Naoki Yoshida, Produzent und Regisseur des Online-Rollenspiels Final Fantasy 14, hat sich in einem Interview…