Kategorie: Technik

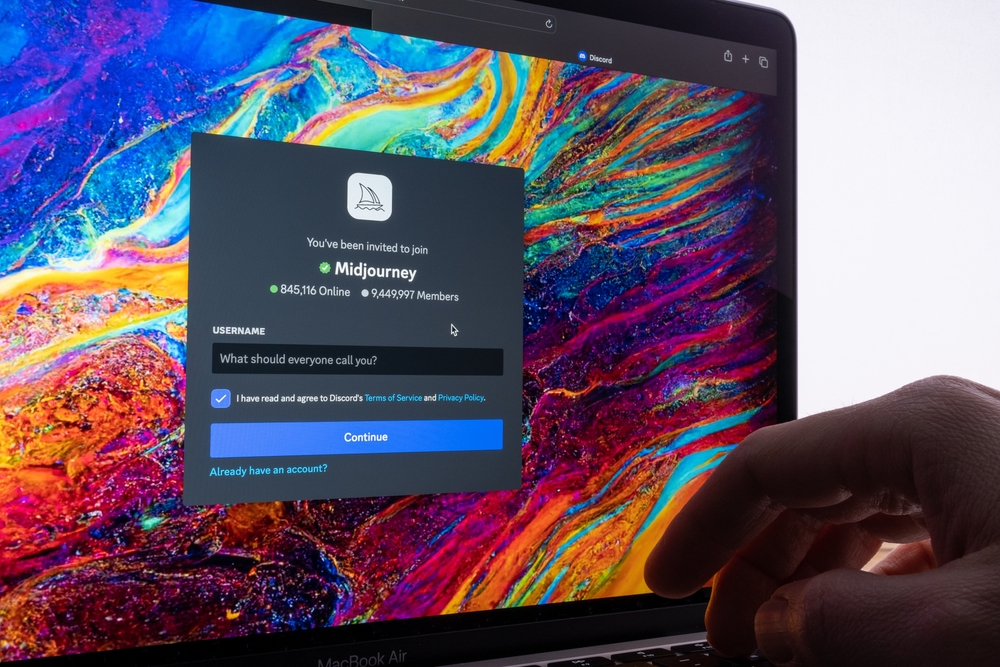

Midjourney: Was es bedeutet und wie es Ihre Reise beeinflusst

Midjourney ist eine Künstliche Intelligenz (KI), die in der Lage ist, Bilder aus natürlichen Sprachbeschreibungen zu erzeugen. Das proprietäre Programm wurde von einem Forschungsinstitut aus [more…]

Netflix Kosten: Preise und Abonnements im Überblick

Netflix ist eine der beliebtesten Streaming-Plattformen weltweit und bietet eine breite Auswahl an Filmen, Serien und Dokumentationen. Die Kosten für ein Netflix-Abonnement variieren je nach [more…]

iPhone 15 im Test: Unser Urteil nach ausführlichem Testlauf

Das iPhone 15 hat die Welt der Smartphones im Jahr 2023 erobert und es ist nicht schwer zu verstehen, warum. Mit seinem schicken OLED-Display, dem [more…]

Wie durch die Pandemie die Digitalisierung vorangetrieben wird

Die Corona-Pandemie bringt auch Vorteile mit sich. Das mag sich zwar zynisch anhören, ist es aber mitnichten. Die Krise zwingt die Länder zu einem Umdenken [more…]

IOS 9 mit Schluckauf

Wenn es um Apple-Produkte geht, dann sind unsere Erwartungen hoch. Kein Wunder: Sie kosten sie weit mehr als die Windows-Erzeugnisse. Apple besticht vor allem durch [more…]

Darum ist das regelmäßige Ändern des Passworts keine gute Idee

Wenn es um die Thematik Passwort geht, dann findet man vor allem im Internet viele Tipps dazu. Der wohl weitverbreitetste Ratschlag ist, dass man sein [more…]

Die Private Cloud

Die Technologie des Cloud-Hostings ist auf dem Vormarsch und führt zu stabileren und robusteren Plattformen bei ihren Softwarelösungen. In der Vergangenheit speicherte ein entfernter Server [more…]

Direct Attached Storage (DAS)

Als DAS “Direct Attached Storage” werden Festplatten bezeichnet, die direkt via USB, SATA, FireWire oder ähnliches an einen Server angeschlossen sind. Man bezeichnet ein DAS [more…]

Das neue Surface Pro 4

Das Surface Pro 4 ist nicht nur irgendein Tablet, sondern der Spitzenreiter unter der Vielzahl an verschiedenen Tablets. Das Display hat eine Zollgröße von 12,3 [more…]